В последнее время ИИ начали ловить галлюцинации. Большинство нейросетей сейчас как злые учителя, которые требуют «выйти и зайти нормально», поскольку на одни и те же вопросы могут выдать разную по смыслу и правдивости информацию.

Проблема не только у моделей OpenAI. В последнем рейтинге галлюцинаций Vectra некоторые «рассуждающие» модели, включая DeepSeek-R1, показали кратный рост галлюцинаций по сравнению с предыдущими версиями.

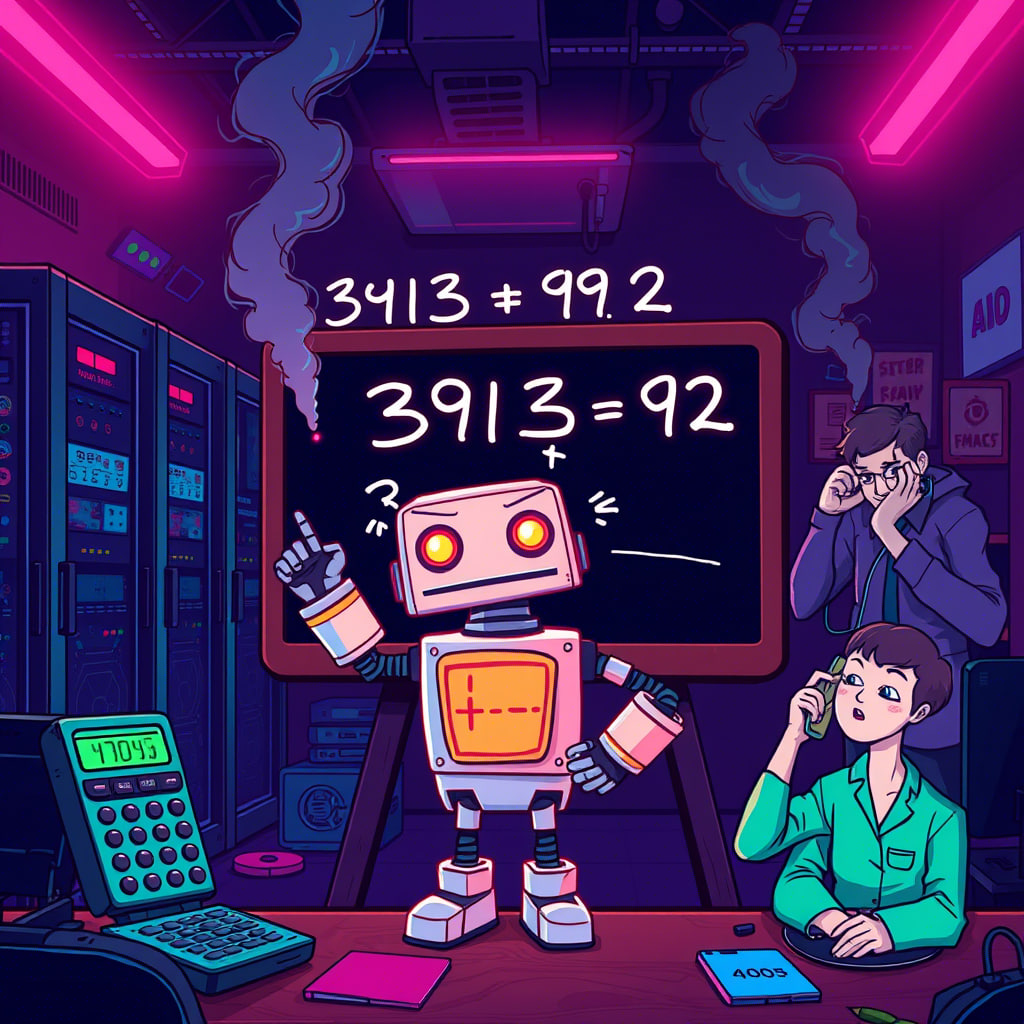

Иногда ИИ не может сложить 3913 и 92, просишь посчитать — а он ошибается. Но если перефразировать как «3913 + 92 =», вдруг всё правильно. Причём порой каждый ответ может быть уникальным — как лотерея.

Почему ИИ не говорит «не могу», а лепит бред? Потому что разработчики сознательно учили его «никогда не отказываться». В итоге — умный, но уверен в своей неправоте.